Hi Stefan,

We hebben de verbose optie uitgeprobeerd. Onze (Engelstalige) developer heeft de volgende terugkoppeling:

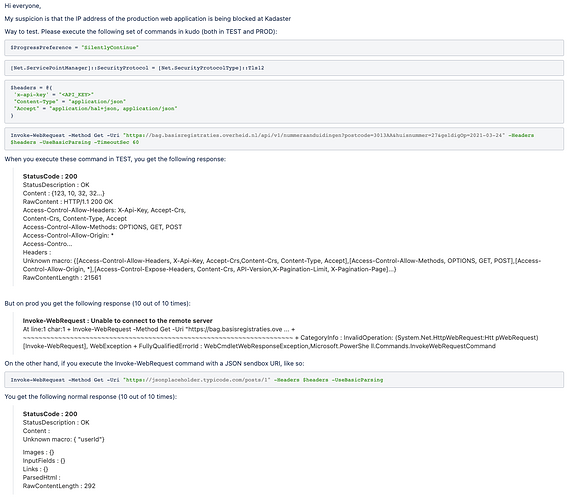

As mentioned above with the tcpping (which differs from a simple ping, trying to actually establish a tcp connection), the request is failing with a timeout.

This issue only presents itself when trying it from the IP’s mentioned above, and it’s random in nature, sometimes working.

Also, port 80 shows no issues connecting, only 443, on these IP’s (a similarly configured environment doesn’t have the issue)

As requested, here is the result of the curl request:

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

0 0 0 0 0 0 0 0 --:–:-- --:–:-- --:–:-- 0* Trying 145.77.103.22:443…

0 0 0 0 0 0 0 0 --:–:-- 0:00:20 --:–:-- 0* connect to 145.77.103.22 port 443 failed: Timed out

- Failed to connect to bag.basisregistraties.overheid.nl port 443: Timed out

Are you sure you don’t enforce any kind of rate limiting per IP?

Regarding the .NET version:

We are using the version you are referencing (4.7.2). Also, we feel that wouldn’t explain why sometimes it works and sometimes it doesn’t. Do you agree?